Что общего у лингвиста, юриста и криминалиста? Теперь их методы работы объединяет в себе нейросетевая платформа AUTOFACTCHECK, созданная в Университете Лобачевского для борьбы с фейками. Система не только изобличает дезинформацию, но и вскрывает контекст, нарративы и манипулятивные приемы. Портал «Живем в Нижнем» узнал, как это работает.

(слева направо): Даниил Буйлов, Юрий Баташев, Алексей Солодовников, Людмила Макарова, Илья Померанцев, Сергей Камнев.

Цифровая эволюция

Сначала система просто проверяла факты: вы загружали текст, а она анализировала, насколько он правдив. Эта идея родилась несколько лет назад как реакция на растущий поток непроверенной информации. Но сейчас откровенную ложь сменили хитрые манипуляции, искажения и скрытые смыслы. Проверки голых фактов уже недостаточно.

«Мы решили перевести фактчекинг (проверку фактов) в плоскость информационной безопасности. Наш инструмент прежде всего позволит соблюсти и государственный интерес: противостоять деструктивному влиянию со стороны недружественных стран с использованием, в том числе, технологий ИИ. Наша программа становится стратегической и общественно значимой», – отметила руководитель центра применения ИИ в журналистике и массовой коммуникации ННГУ Людмила Макарова.

Платформа, которую создают в Университете Лобачевского, превращается в детектива: она изучает преподнесенный ей текст как лингвист, юрист и эксперт-криминалист одновременно. База осталась прежней: система находит в тексте факты и сверяет их с надёжными источниками. Но теперь вместо простого ответа «правда или ложь» она проводит глубокий анализ по девяти (а скоро и десяти) параметрам.

Грани истины

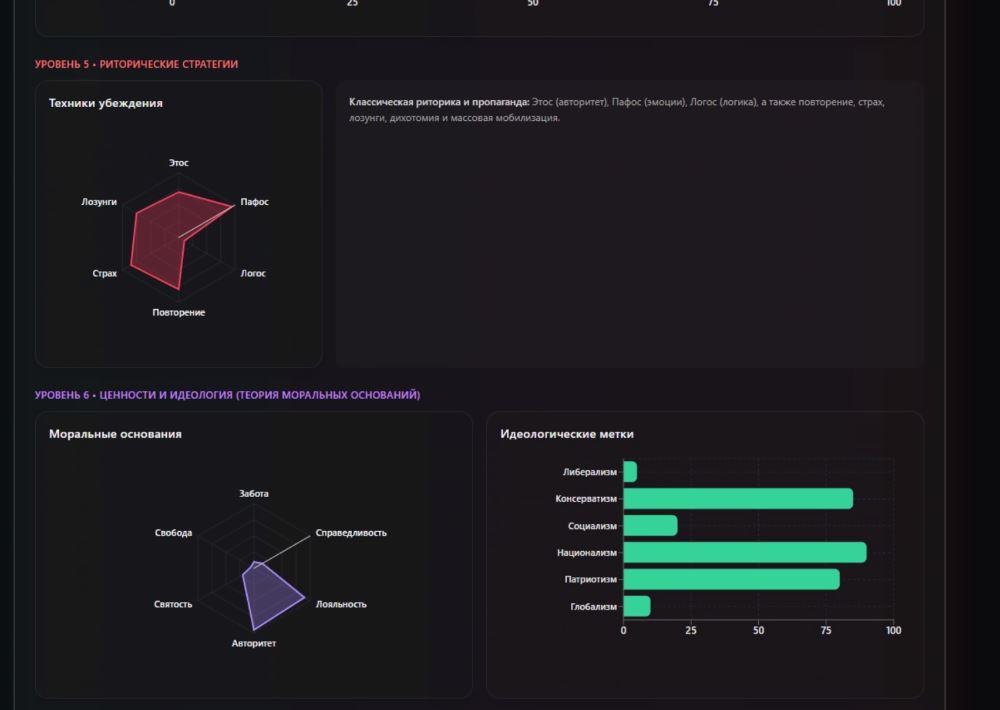

Нейросеть понимает, какую позицию или ценности продвигает текст. Её обучили на множестве примеров, поэтому она может распознать даже новые, ранее незнакомые идеи, анализируя слова-маркеры и общий контекст. Система находит логические ошибки и манипуляции, например, когда цитаты вырывают из контекста или пытаются провоцировать эмоции. Таким образом можно увидеть, как именно вас хотят обмануть.

«Мы ведем активную работу с лингвистами, чтобы выявить нарратив, который можно условно отнести к определенному смысловому дискурсу. Это можно сделать, если знать примеры различных нарративов и их признаки», — говорит лаборант-исследователь центра применения ИИ в журналистике и массовой коммуникации ННГУ Даниил Буйлов.

Нейросеть «ловит» оскорбления и потенциальные деструктивные призывы. По словам разработчиков, главное здесь — контекст. Одно слово само по себе ничего не значит, но в определённой ситуации оно может стать опасным оружием.

Система «сканирует» эмоции и изучает, как текст влияет на наше восприятие. Она определяет, как автор преподносит проблему, предлагает ли решения, выносит ли моральные суждения, и что он на самом деле хочет: просто сообщить новость или подтолкнуть вас к действию. Также программа автоматически определяет тему: политика, экономика, здоровье и т.д. Весь этот разбор система выдает не в виде скучного отчета, а в наглядных и понятных графиках.

Технологии и философия

«Мозгом» системы может стать любая современная нейросеть — зарубежная (вроде GPT или DeepSeek) или российская, например, Giga Chat. Разработчики тестируют разные модели, чтобы выбрать самую эффективную. Cкоро результаты работы проекта станут более эффективными: команда переносит систему на собственное оборудование, приобретенное по программе «Приоритет 2030». Свое «железо» сделает ее независимой и позволит масштабировать проект без оглядки на сторонних поставщиков.

Сейчас платформа собирает и анализирует данные только с сайтов. Однако команда намерена начать работать и с соцсетями, и с мессенджерами (в первую очередь, Telegram), где немного другая структура данных. А еще планируется перевод аудио и видео в текст с последующим полным анализом и работа со ссылками, которые содержат в себе информацию для проверки. Не исключено, что в будущем нейросеть сможет сама искать в Сети нужные публикации.

«Есть два подхода к проблеме распространения недостоверного и негативного контента: запретить или создать инструменты, которые позволят его регулировать. Мы видим свою задачу в создании экосистемы проверенной информации, которая позволит без запретов просто подсвечивать негативный, манипулятивный контент. Это история попытки уйти от запретительных мер в сторону свободы слова, свободного интернета, свободного пользования технологий ИИ», – объяснил младший научный сотрудник центра применения ИИ в журналистике и массовой коммуникации ННГУ Илья Померанцев.

Идея заключается в том, чтобы дать и рядовому пользователю, и СМИ, и госорганам продвинутый инструмент для анализа. С его помощью СМИ смогут повысить свою репутацию, читатели — критически оценивать информацию, а власти — точечно реагировать на действительно опасный контент.